2. 크롤링 코드 패턴

- Python/파이썬 크롤링

- 2021. 6. 17.

크롤링을 하기위한 기본적인 코드의 패턴을 알아보자.

# 1. 라이브러리 임포트

import request

from bs4 import BeautifulSoup

# 2. 웹페이지 가져오기

res = requests.get('http://v.media.daum.net/v/20170615203441266') # 웹페이지 정보가 res 변수로 들어감

# 3. 웹페이지 파싱하기

soup = BeautifulSoup(res.content, 'html.parser')

# 4. 필요한 데이터 추출하기

mydata = soup.find('title')

# 5. 추출한 데이터 활용하기

print(mydata.get_text())

크롤링을 하기위해 필요한 2가지 라이브러리

- requests

- 웹페이지 가져오기 라이브러리

- bs4 (BeautifulSoup)

- 웹페이지 분석(크롤링) 라이브러리

크롤링을 위한 기본적인 웹 기본 구조의 이해가 필요하다.

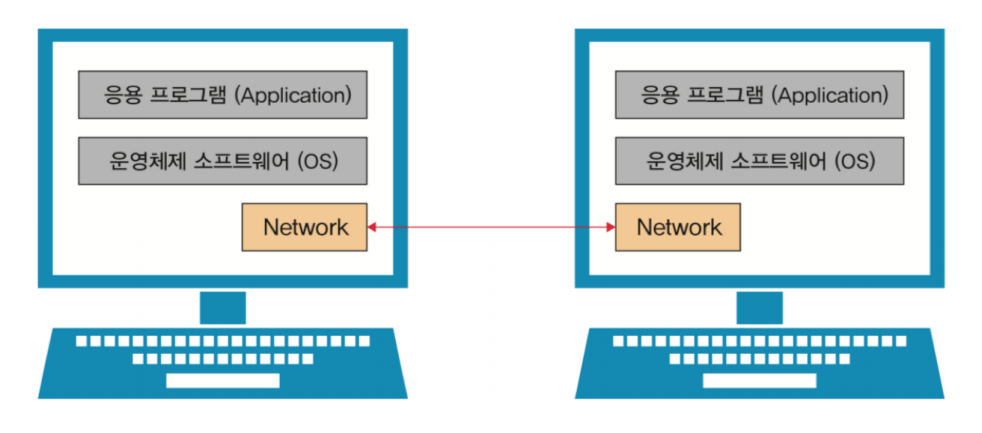

인터넷 기술이 발전하면서 컴퓨터 안에 Network 부품(하드웨어)이 껴서 들어감. 이 부품을 통해 내 컴퓨터와 다른 컴퓨터를 연결하고 정보를 주고 받을 수 있게 됨.

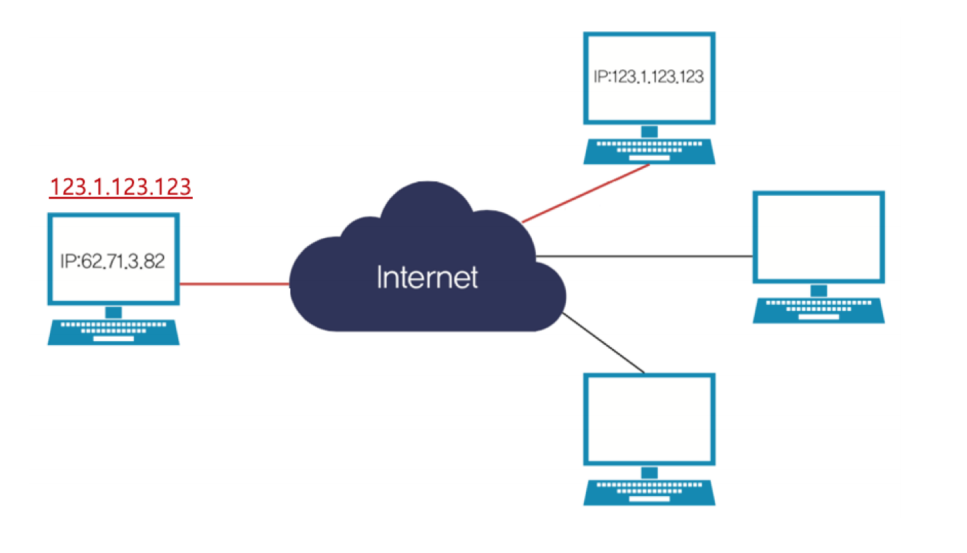

여기서 인터넷은 전세계의 많은 컴퓨터들을 네트워크 부품을 통해 연결 시켜준다. 이때 내컴퓨터에 특정 컴퓨터의 정보를 가져오고 싶다면 그 특정 컴퓨터를 지칭하는 정보가 필요함. 그게 바로 IP 주소이다. ex)123.123.11.51

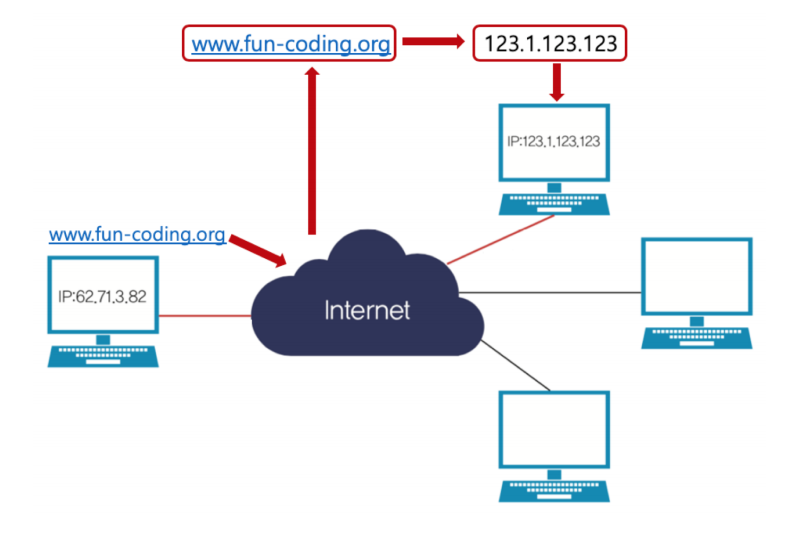

근데 IP주소가 숫자로 되있으면 기억하기 힘들기 때문에 'www.fun-coding.org' 같은 특별한 이름으로 표기하는 기술을 만듦. 그래서 내 컴퓨터에서 저 주소를 치면 internet 망에서 알아서 그 컴퓨터의 주소로 찾아가서 정보를 얻을 수 있게 도니다.

여기서 인터넷 웹페이지의 동작원리를 보면, 내 컴퓨터의 웹 브라우저에 주소를 치게되면 그 주소에서 html언어로 구성된 파일을 얻게된다. 그 전달받은 파일을 웹브라우저상에서 화면에 보여주게 됨.

다시 코드로 돌아와서

res = requests.get('https://new.v.daum.net/v/20170515203441266')

print(res.content)👉result

다음과 같이 html언어를 return하게 된다.